春节期间网上全是 DeepSeek 的各种消息,

开工的这两天正好有空,看看 36G 的 MBP 能否带动 deepseek-r1:32b。

物料

- 16英寸 Macbook Pro - M3 Pro 12C CPU, 18C GPU, 36GB Memory, 1TB SSD storage

- ollama - 开源的大型语言模型(LLM)平台,用来像

Docker一样管理和运行模型 - deepseek-r1:32b - DeepSeek 的第一代推理模型

- Page Assist - 本地 AI 模型的 Web UI

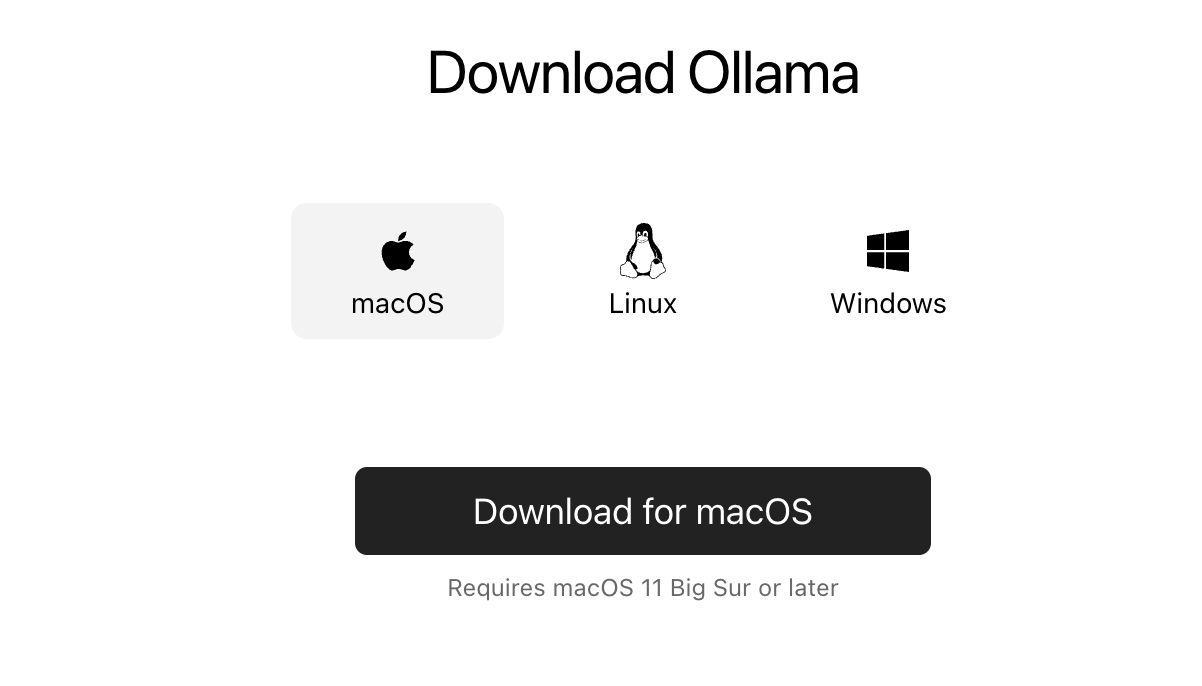

安装 Ollama

ollama 支持 macOS、Linux、Windows,前往 ollama/download 下载应用安装即可,

macOS 下载会得到一个 Ollama-darwin.zip 文件,解压后将 ollama.app 移动到应用中,并运行它,

通过命令行输出版本号可以验证是否运行正常。

ollama --version

ollama version is 0.5.7下载模型

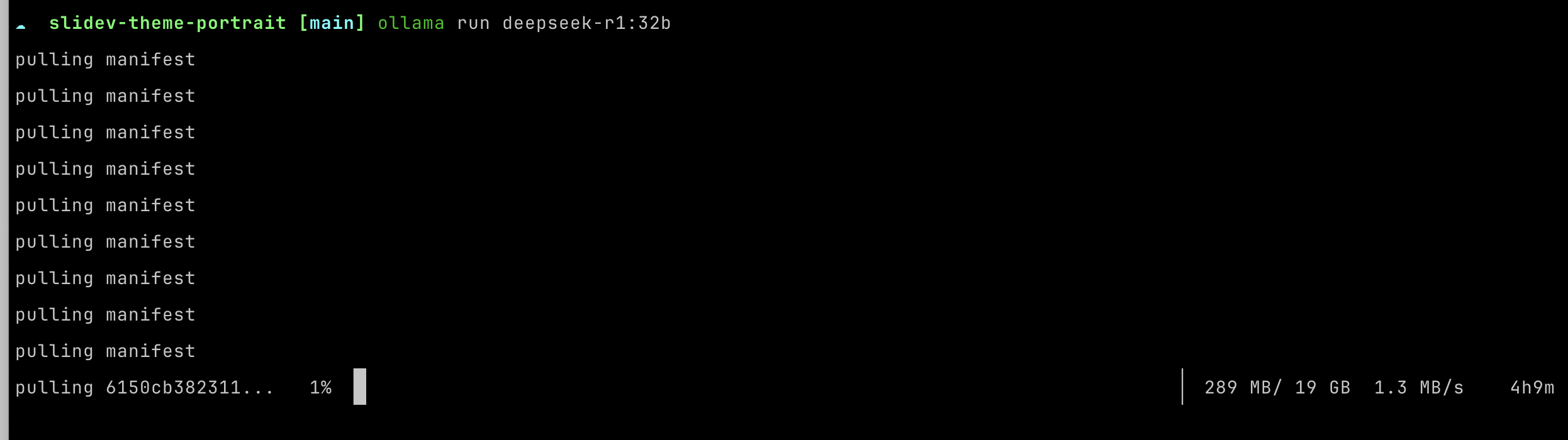

由于模型从未下载过,执行 pull 或 run 都会开始下载模型:

ollama pull deepseek-r1:32bollama run deepseek-r1:32b

32b 的模型有 20GB,下载时间取决于网速,建议一大早下载或者挂一晚上吧。

02.07 白天 10:00 开始下载,一直到 18:00,才下了 4GB,速度 200kb/s ~ 2mb/s:

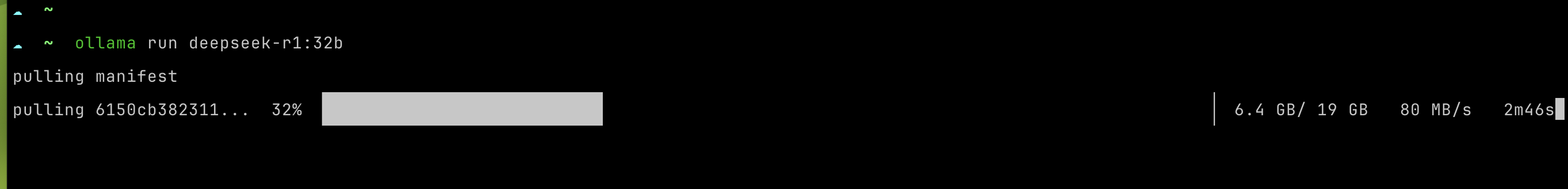

02.08 早上 7:00 重新下载,带宽拉满,速度 85mb/s 左右,5分钟左右下完:

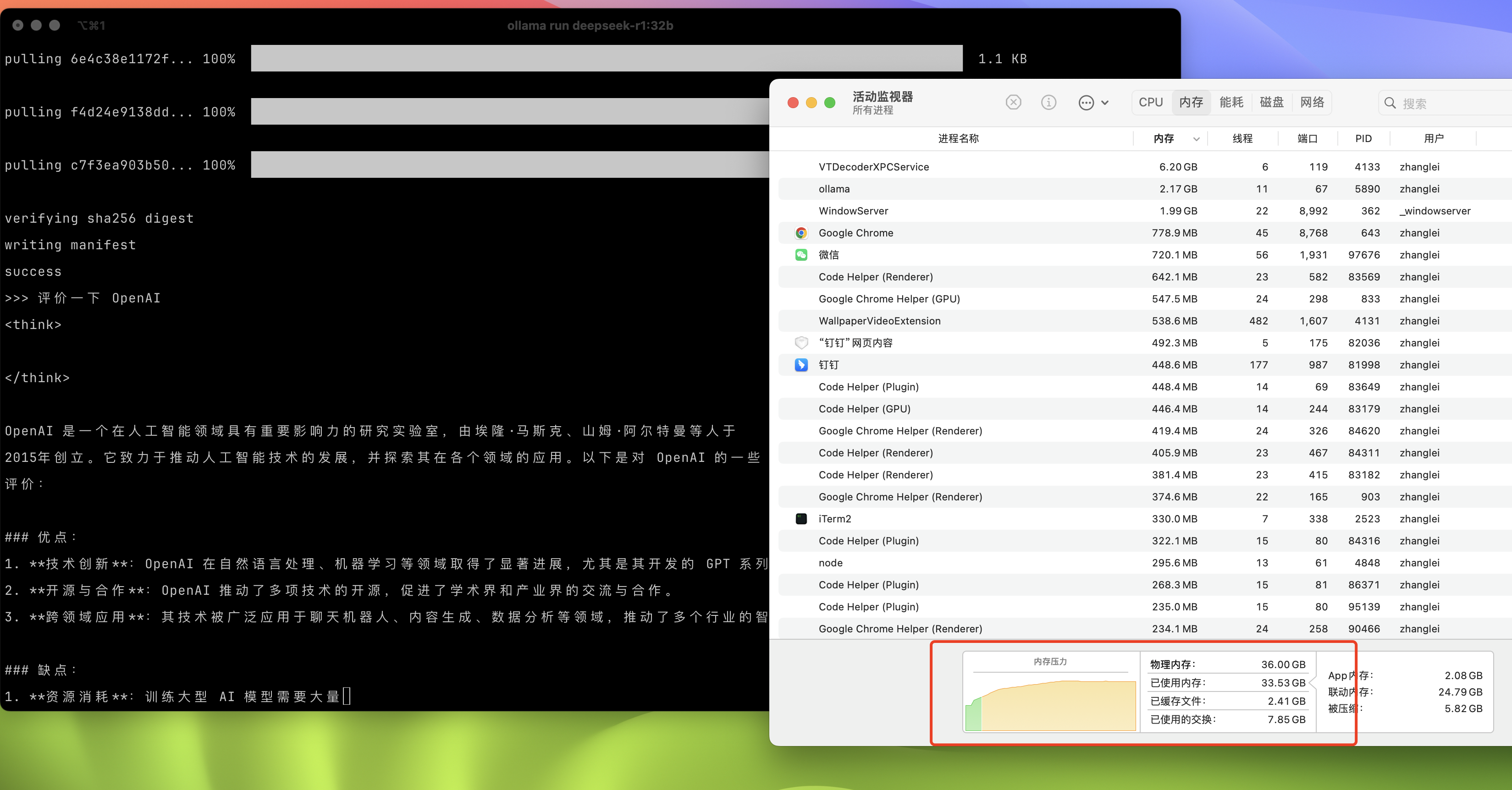

对话模型

简单的发起了一次对话,思考时间有些久,不过内存压力还不算太大。

Web UI

现在有很多开源的 Web UI 可以对接本地大模型,这里我选择最简单的浏览器插件:Page Assist,

安装 Page Assist 并开启联网搜索后,再发起一次对话验证效果。

阿格莱亚 发布于 2025-02-05: